不太明白,观测到的数据不就是已经在现实中出现了吗?那不就是概率=1 吗?

还有个问题是,在linear regression推论里,噪声服从正态分布怎么得出 given x, y就服从一样的正态分布呢?在几何意义上怎么理解呢?

y(true) = wx+b+epsilon, 当讨论y|x的时候,是由于每个x值相同的点对应到公式上是epsilon不一样导致最后y值不一样的吗?

老师在回复中写“多个相互独立事件发生的联合概率”,在这里多个相互独立事件指的是观测数据在现实中出现的概率,观测数据是哪些?哪些是在现实中出现的?既然观测数据就是在现实中出现的了,那所谓概率是谁相对于谁的概率?和我们的表达式又有什么关系?

连乘这个操作,把x相等的点也互相都乘进去了,意思是我们看概率是一个点一个点看的吗?

比如我有观测到(0,1)(0,2)(0,1)(0,2)(0,2)(0,3)(0,4)(1,4)(3,4),然后用y=wx+b+epsilon进行参数估计,老师可以用这个例子把整个过程讲一遍吗?现在都是数学公式太抽象了

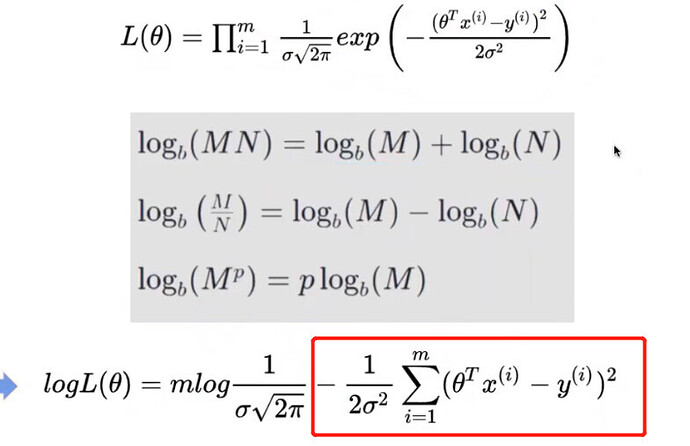

课上讲最大似然估计法后直接引入wx+b+epsilon表达式了,好像跟squared loss没有什么关系,是不是只是最后写公式发现其中有一部分刚好是squared loss function?为什么不直接求squared loss 的最小值呢?